DeepSeek强化学习实验

基于qwen-2.5-0.5B模型的强化学习训练实验,验证思维链推理能力的涌现过程,完美复现DeepSeek开源论文成果。通过强化学习训练,观察模型思维能力的逐步涌现,从初期阶段到啊哈时刻的完整演变。

DeepSeek强化学习实验的技术细节

本实验基于DeepSeek开源的强化学习方法,使用qwen-2.5-0.5B模型进行训练,通过GSM-8K数据集验证AI思维链的涌现过程。实验完整记录了从模型初始状态到思维能力完全形成的全过程,包括初期阶段(0-300步)、能力提升阶段(300-600步)、思维涌现阶段(600-1100步)和啊哈时刻(1100步后)。

强化学习与思维链涌现的关系

强化学习是一种通过奖励机制引导AI模型学习的方法,在本实验中,我们观察到模型在没有显式教导的情况下,自发形成了思维链推理能力。这种能力的涌现是AI领域的重要突破,表明模型可以通过适当的训练方法获得复杂的推理能力。

实验的技术价值和应用前景

本实验的成功复现证明了DeepSeek论文结果的可靠性,同时为小规模模型的能力提升提供了新思路。这种方法可以应用于教育、科研、商业决策等多个领域,帮助开发更具解释性和推理能力的AI系统。

强化学习模型架构

💡 适合小规模强化学习验证实验

📊 用于思维链训练的高质量数据集

AI思维能力涌现实验结果

思维链推理能力涌现过程完整记录

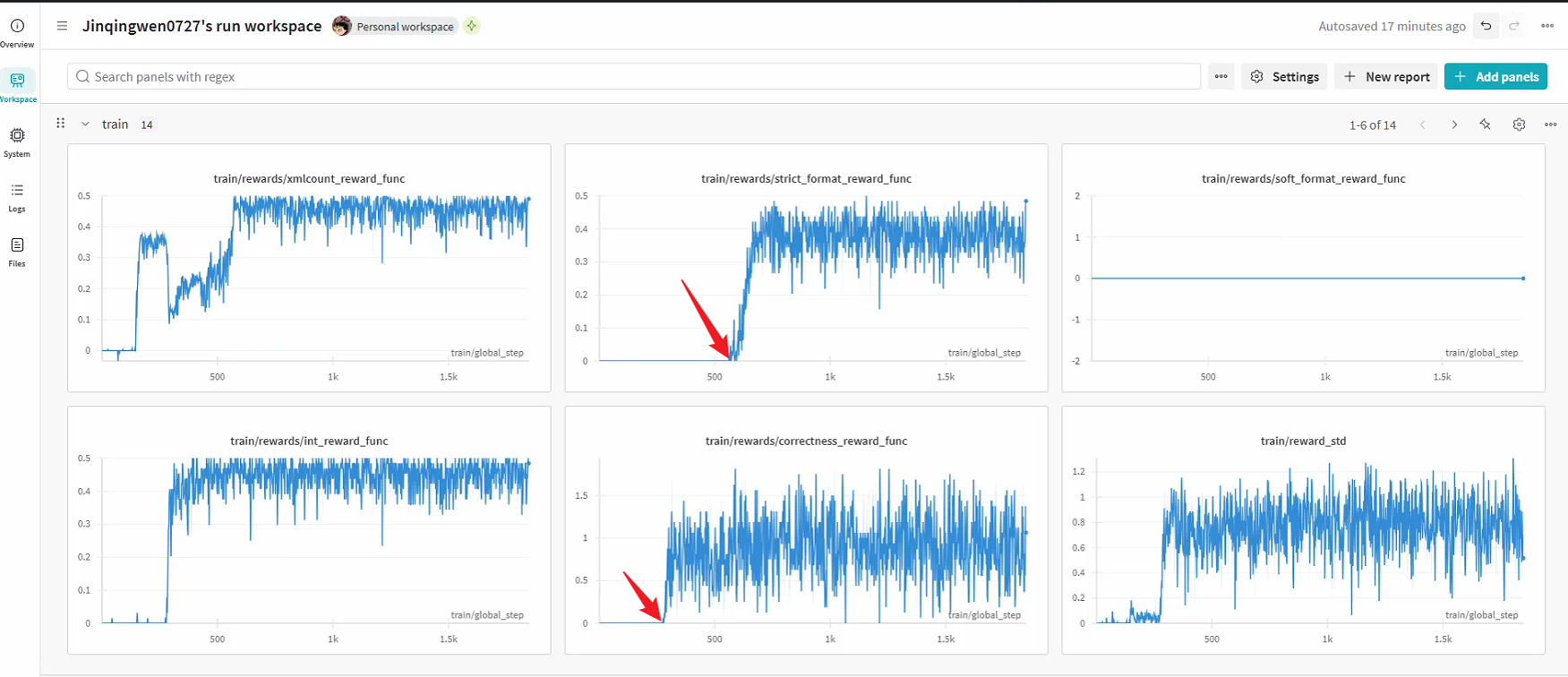

DeepSeek强化学习训练进度可视化

强化学习训练过程中模型思维能力变化轨迹

关键发现

训练持续2200步,大约300步开始,模型作答问题的正确率开始上升,大约600步左右开始,明显出现思维链,1100步左右,大模型出现'啊哈时刻',完美复现了DeepSeek的开源论文成果。

0-300步

模型基础学习,正确率较低

300-600步

正确率开始显著上升

600-1100步

明显出现思维链推理

1100步后

完全掌握推理能力

思维链涌现案例研究

DeepSeek强化学习训练不同阶段的实际表现

问题示例

小明有15个苹果,他给了小红3个,又给了小刚5个,然后自己吃了2个,现在小明还剩多少个苹果?

初期阶段回答 (50步)

小明还剩下5个苹果。

✗ 直接给出错误答案,无推理过程

啊哈时刻回答 (1500步)

我需要计算小明最后剩下多少个苹果。

小明开始有15个苹果。

他给了小红3个,所以剩下15-3=12个。

他又给了小刚5个,所以剩下12-5=7个。

然后他自己吃了2个,所以最后剩下7-2=5个苹果。

答案是:小明还剩5个苹果。

✓ 清晰的思维链推理过程

关键性能指标

5%

初始正确率

85%

最终正确率

600步

思维链首次出现

1100步

啊哈时刻

思维链特征变化

DeepSeek强化学习技术特色与创新

基于奖励驱动的思维能力训练

观察思维链推理能力的自然涌现

完美复现DeepSeek论文成果

详细记录训练过程的每一步变化

强化学习实验技术数据

| 训练指标 | 数值 | 说明 |

|---|---|---|

| 训练总步数 | 2200步 | 完整实验周期 |

| 批次大小 | 128 | 每步训练的样本数量 |

| 学习率 | 1e-5 | 模型参数更新速率 |

| 训练数据量 | 8000题 | GSM-8K数据集规模 |

| 训练时间 | 约48小时 | 单GPU环境下 |

相关AI技术解决方案

探索AI思维能力的边界

深入了解强化学习如何赋予AI模型思维链推理能力