模型蒸馏技术

针对清华大学终身教育处广告审核业务需求,通过知识蒸馏技术将DeepSeek R1 671B大模型的审核能力迁移到8B小模型,实现本地部署的高效审核服务,解决传统审核流程中的效率和成本问题,是AI知识迁移与小模型优化的典型应用。

模型蒸馏技术的核心优势

模型蒸馏是一种将大型AI模型的知识和能力迁移到更小模型的技术,通过让小模型(学生模型)学习大模型(教师模型)的输出和行为模式,使小模型获得接近大模型的性能,同时保持更低的计算资源需求。在本项目中,我们成功将DeepSeek R1 671B大模型的广告审核能力迁移到了8B小模型,实现了本地部署的高效审核服务。

模型蒸馏的技术价值

模型蒸馏技术解决了大型AI模型部署成本高、计算资源需求大的问题,使企业能够以更低的成本获得接近大模型的性能。通过知识蒸馏,小模型可以学习大模型的决策边界和推理过程,而不仅仅是简单模仿输出结果,从而在特定任务上达到更高的精度。

模型蒸馏的应用场景

模型蒸馏技术广泛应用于需要在资源受限设备上部署AI模型的场景,如移动设备、边缘计算设备等。此外,在需要低延迟响应的实时系统中,如广告审核、内容过滤、实时翻译等,模型蒸馏也能发挥重要作用,提供高效的AI服务。

模型蒸馏项目背景

Knowledge Distillation

模型蒸馏技术方案

教师模型 (Teacher Model)

deepseek-r1:671b 大模型

6170亿参数 - 强大的审核能力

知识蒸馏过程 (Knowledge Distillation)

学生模型 (Student Model)

deepseek-r1:8b 小模型

80亿参数 - 适合本地部署

提示工程优化

学校提炼好的广告审核规则

高质量训练语料

236个培训项目的广告案例

模型蒸馏应用场景

非学历培训项目广告内容审核

知识蒸馏效果展示

模型蒸馏训练结果对比分析

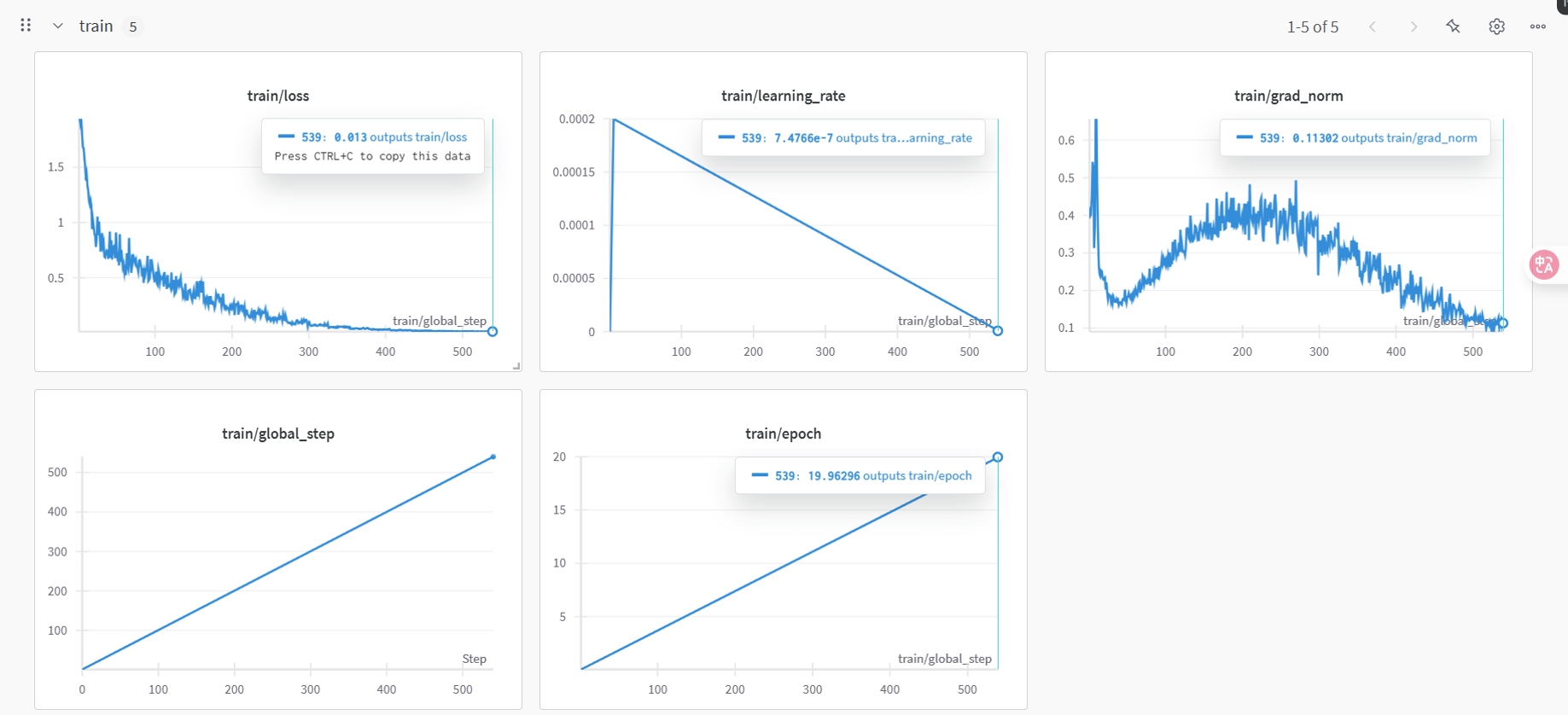

模型蒸馏训练结果可视化

知识蒸馏过程中模型性能提升轨迹

模型蒸馏成果总结

通过知识蒸馏技术微调后的小模型,提示词模板固化

针对培训项目广告的审核结果输出内容质量与671B大模型几乎一致

(由于过拟合,微调后模型多轮对话能力消失,但这不影响其作为审核API提供服务)

蒸馏后小模型输出的审核结果与大模型已基本没有区别

Distilled model responses match the full model

知识蒸馏后的思考过程非常严谨,继承了大模型的推理能力

Rigorous reasoning process after distillation

小模型经过知识蒸馏后输出准确性显著提升

Significantly improved output accuracy

模型蒸馏案例研究

清华大学终身教育处广告审核实际应用效果

审核场景

清华大学终身教育处每月需审核约200个培训项目的广告内容,确保合规性和准确性,审核工作量大且要求高。

蒸馏前 (原8B模型)

• 审核准确率:65%

• 每项审核时间:约15分钟

• 需要人工复核:大部分

• 部署成本:较低

蒸馏后 (优化8B模型)

• 审核准确率:92%

• 每项审核时间:约3分钟

• 需要人工复核:少部分

• 部署成本:较低

✓ 显著提升审核效率与准确性

关键绩效指标

80%

审核时间节省

90%

计算资源节省

27%

审核准确率提升

100%

数据安全保障

投资回报分析

模型蒸馏技术特色与创新

将大模型知识迁移到小模型,实现能力传承

专门针对广告审核业务场景定制训练

降低计算成本与提高数据安全性

大幅提升小模型性能与现有规模

相关AI解决方案

探索我们的其他AI技术与服务

探索模型蒸馏技术的商业价值

了解如何通过知识蒸馏技术降低AI部署成本,提升小模型的专业能力

我们为各行业提供专业的模型蒸馏与AI知识迁移服务,帮助您降低AI部署成本